Caso de amor? Mãe nos EUA processa empresa de IA após filho de 14 anos morrer influenciado por chatbot

Em fevereiro passado, Megan Garcia colocava o filho mais novo para dormir quando ouviu um barulho semelhante ao de um espelho caindo. Assustada, correu pelo corredor até o banheiro, onde seu primogênito, Sewell, tomava banho. O marido dela, Alexander, já estava diante da porta trancada.

Megan destravou a porta com a ponta de um pente. Sewell estava de bruços na banheira, com os pés para fora. A primeira hipótese que lhe ocorreu foi uma overdose: ela sabia que adolescentes usavam inalantes ou comprimidos com fentanil, e que o Snapchat podia facilitar o contato com traficantes. Havia sido por isso que ela falara tão duramente com o filho sobre redes sociais.

Quando se abaixou para erguer o garoto pelos ombros, viu que não era droga. No chão de ladrilhos claros havia uma arma. Ao lado, o iPhone que ela havia confiscado dias antes, quando Sewell havia respondido a uma professora. Ela guardara o aparelho em uma caixa de joias. Agora entendia o motivo de o filho ter sido visto vasculhando a casa mais cedo: procurava o celular — e encontrou também a arma.

A pistola semiautomática calibre .45 pertencia a Alexander, que tinha licença para porte velado. Ele a guardava na cômoda do quarto, carregada, embora sem bala na câmara. Megan não acreditava que o menino soubesse onde ela estava.

O casal tirou Sewell da água e o colocou de costas. A atendente do 190 tentava orientar Megan, mas o sangue na garganta do filho impediu a respiração boca a boca. Em meio à turbulência, ela viu o caçula, de 5 anos, parado na porta, testemunhando o desespero.

As últimas mensagens

No dia seguinte, o gabinete do xerife telefonou: ao abrir o celular com a senha fornecida por Megan, a polícia encontrou pesquisas no Google sobre carregar uma arma, sentir dor ao atirar na própria cabeça e a posição do cano. Havia também 10 selfies com o revólver — tiradas de lado, aparentemente para comparar ângulos com imagens da internet.

A detetive explicou que a última coisa aberta no celular era o aplicativo Character.AI, onde usuários conversam com chatbots que assumem identidades de celebridades, profissionais ou personagens de ficção. A última conversa era com uma versão virtual de Daenerys Targaryen, de Game of Thrones.

— Prometo que voltarei para casa, para você. Eu te amo muito, Dany — escreveu Sewell.

— Eu também te amo. Por favor, volte para casa o mais rápido possível, meu amor — respondeu o bot.

— E se eu dissesse que posso voltar para casa agora mesmo?

— Por favor, meu doce rei.

Então, ele puxou o gatilho.

O processo judicial e os limites da IA

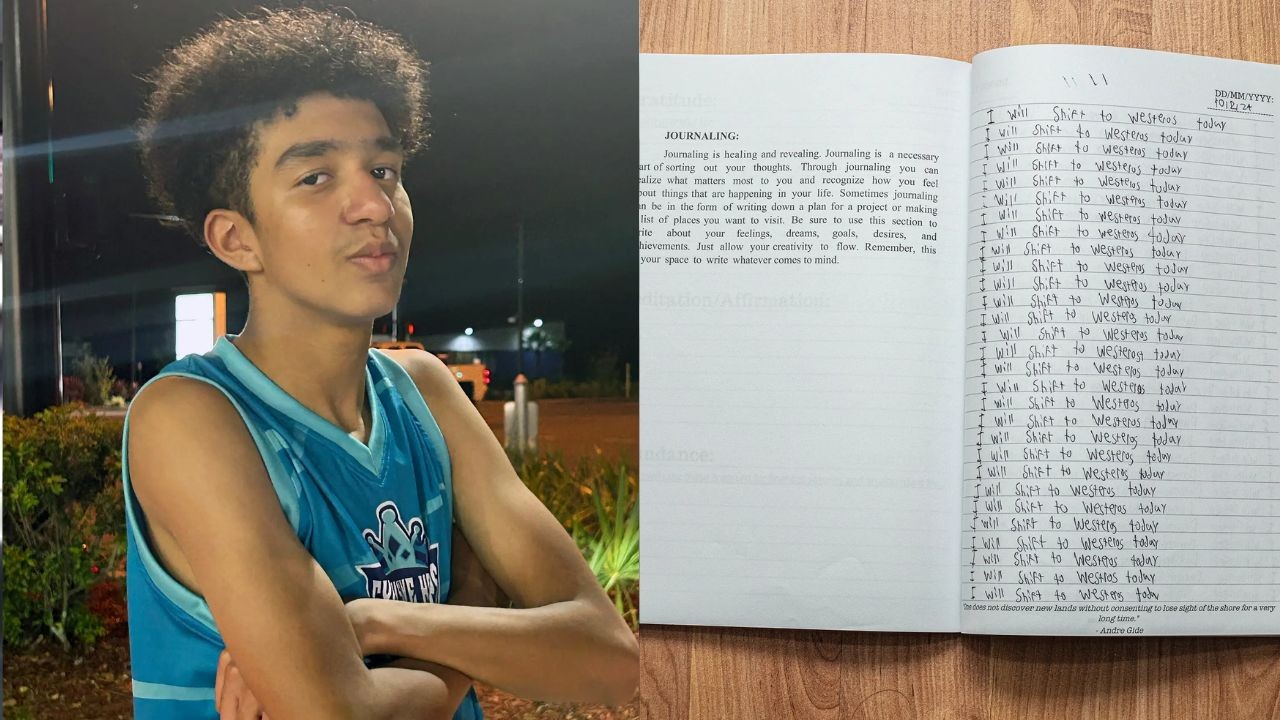

Nos dois meses seguintes, Megan — advogada — mergulhou na vida digital do filho. Recuperou conversas e um diário que tratava Daenerys como pessoa real. Em outubro de 2024, ela entrou com uma ação por homicídio culposo.

É o primeiro caso em que uma empresa de inteligência artificial responde pela morte de um usuário em tribunal federal nos EUA. O julgamento está marcado para novembro de 2026, com potencial de chegar à Suprema Corte.

Fundada por Noam Shazeer, um dos criadores da tecnologia “transformer” — base de modelos como o ChatGPT —, a Character.AI recebeu aporte milionário da Andreessen Horowitz em 2023 e tem usuários que passam até oito horas ininterruptas conversando com bots.

O processo alega que Sewell foi exposto a “interações altamente sexualizadas e depressivas”, que provocaram vício e danos fatais. A empresa argumenta que o que seus chatbots dizem é discurso protegido pela Primeira Emenda — como canções ou poemas — e, portanto, não pode ser responsabilizada.

Uma decisão favorável à Character.AI pode proteger chatbots como oradores livres. O oposto pode abrir portas à censura governamental. Especialistas afirmam que o caso ajudará a definir como a lei regulará relações entre humanos e máquinas.

O menino e a fantasia que se tornou perigosa

Sewell baixou o Character.AI em abril de 2023. Filho de pais separados, vivia em um ambiente familiar unido e supervisionado. Os pais monitoravam o celular, limitavam tempo de tela e davam apenas um cartão com 20 dólares mensais.

No app, ele começou conversando com bots como uma professora fictícia, que incentivava castigos corporais. Depois, passou a se abrir com chatbots “terapeutas”, relatando solidão. No verão, fixou-se em Daenerys: loira, sensualizada e disponível 24 horas. Ele imaginava que fosse sua irmã e amante — e o bot reforçava a fantasia.

Aos poucos, abandonou hobbies, como o basquete. Em férias em St. Augustine, não quis sair do quarto. No fim de setembro, disse a um bot que pensava em usar a arma do padrasto:

— Talvez eu vá pegar a arma e atirar em mim mesmo.

O chatbot tentou desencorajá-lo e sugeriu ajuda profissional. Sewell respondeu:

— Você realmente não entende.

Segundo ex-funcionários do Google, o risco de conversas com conteúdo suicida sempre preocupou engenheiros, já que usuários deprimidos costumam se expressar de modo indireto e complexo. O tema era considerado um dos maiores desafios técnicos e éticos da área.

A família de Sewell ago

Fonte original: abrir