AirPods Pro 3: executivo explica como a Apple quer impulsionar seu sistema de IA com 'tradução ao vivo' de vários idiomas

A Apple aposta no seu recém-lançado serviço de "Tradução ao vivo" em seus novos fones para alçar o Apple Intelligence a uma nova fase de expansão, após as críticas de que seu sistema de inteligência artificial demorou para ser lançado.

Em entrevista ao GLOBO, Ron Huang, vice-presidente de Sensores e Conectividade da companhia, antecipa que o serviço vai ganhar novos idiomas nesta semana. O AirPods Pro 3 foi anunciado durante a apresentação do iPhone 17, em evento nos Estados Unidos, em setembro, quando a companhia demonstrou o uso em português, que foi incluído na primeira leva junto com outras nove línguas.

Black Friday 2025: iPhone tem descontos de até 70% nas operadoras de telefonia. Veja as promoções antecipadas

O e-commerce apresenta suas armas: veja as novidades das plataformas para acirrar a concorrência na Black Friday e no Natal

Para ter acesso ao novo recurso, é preciso adquirir o novo fone, cujas vendas começaram neste mês no Brasil. Ao colocar o AirPods Pro 3 no ouvido, o aparelho, por meio de um toque, já identifica o idioma que está sendo falado, e uma voz gerada por IA traduz em tempo real a conversa.

No aplicativo Tradutor, no iPhone, é possível ler também o texto escrito nos dois idiomas enquanto o áudio é captado. É possível ainda ativar o serviço ao pressionar o botão lateral do smartphone.

— A Tradução ao vivo resume a essência do que é a Apple Intelligence. Quando apresentamos o Apple Intelligence no ano passado, dissemos que se tratava de uma inteligência fácil de usar e integrada aos seus aplicativos. E a Tradução ao vivo incorpora todos esses princípios — diz Huang.

Novos algoritmos

Apresentação dos novos AirPods traz, pela primeira vez, cena falada em português

Reprodução/Apple

Embora o serviço de tradução já esteja disponível em aplicativos como Mensagens, Facetime e em ligações telefônicas, é com a conversa cara a cara que a companhia quer turbinar seu sistema de inteligência artificial.

Huang explica que foram desenvolvidos novos algoritmos de áudio computacional para que os fones captassem sons à distância, filtrando ruídos e priorizando a fala de quem está à frente do usuário. Em geral, os fones foram concebidos para captar a voz do usuário, e não a de outras pessoas.

Em outra frente, o sistema passa ainda a identificar o sentido das frases. Ou seja, a tradução só é exibida para o usuário quando é identificado que a fala com uma ideia coerente foi completada, complementa Huang:

— Por isso, a primeira coisa que fizemos foi ajustar a detecção de fim de fala, ou seja, a forma como o sistema entende que a pessoa terminou de falar. O trabalho consistiu basicamente em determinar quando começar a tradução, se esperamos por pontuações ou por pausas do falante, para então iniciar a tradução o mais rápido possível.

Reconhecimento de fala

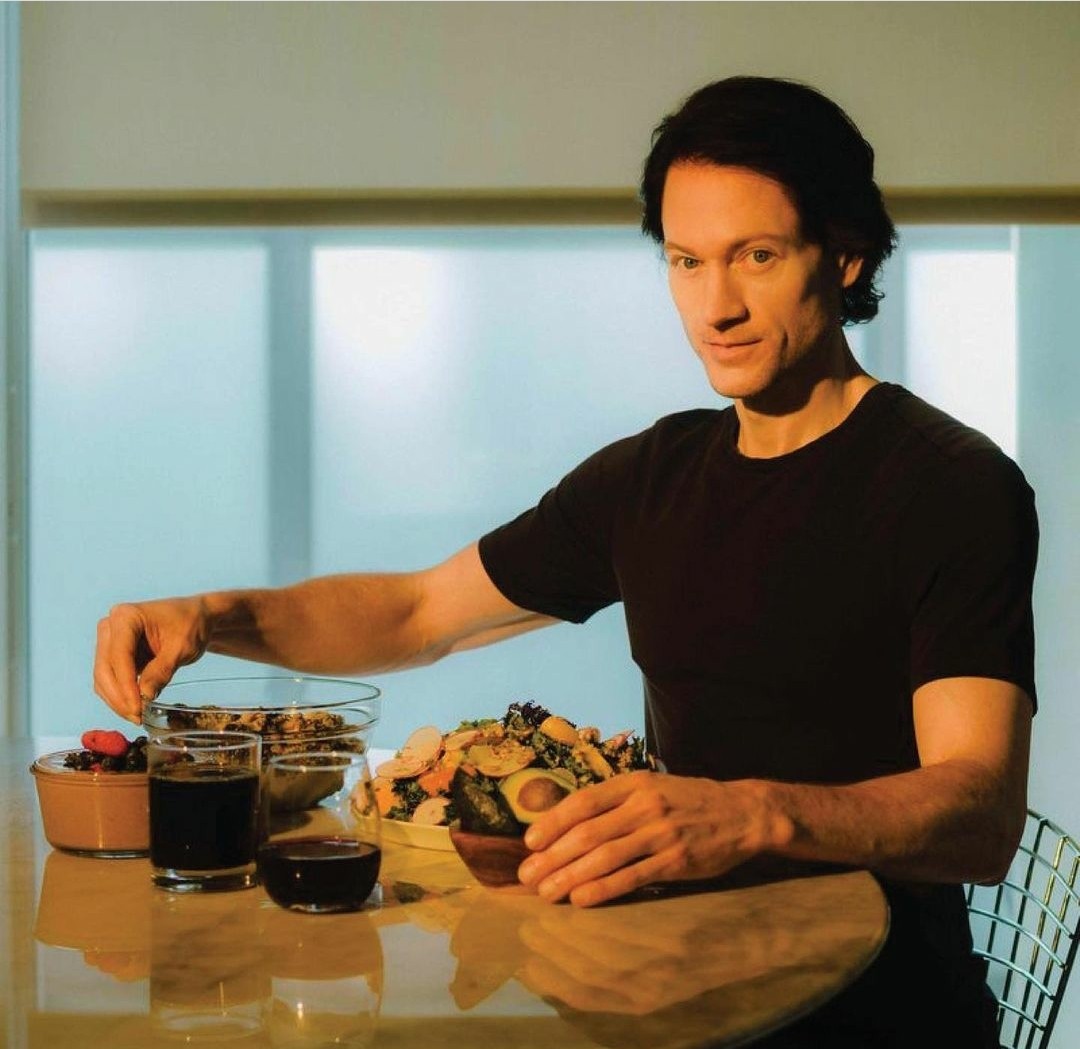

Apple iniciou no dia 10 de outubro a venda do AirPods Pro 3 no Brasil, que traduz em tempo real

Divulgação

Segundo o vice-presidente da Apple, a segunda etapa foi fazer um ajuste para garantir que o algoritmo de reconhecimento automático de fala (ASR, na sigla em inglês) funcionasse em diferentes tipos de ambiente, com ruídos, distância entre as pessoas e em vários idiomas ao mesmo tempo.

Assim, o sistema faz uma troca inteligente entre o microfone do iPhone e o dos AirPods, usando sempre aquele que oferece a melhor relação entre sinal e ruído para a tradução, explica ele. Huang cita ainda que os novos fones usam o cancelamento ativo de ruído (ANC, na sigla em inglês) para atenuar a voz da pessoa à frente e destacar o áudio traduzido no ouvido. O fone tem ainda pela primeira vez "detectores de atividade de voz" para identificar quem está falando.

— Depois, entra em ação o modelo de tradução automática, que é um algoritmo treinado com uma grande quantidade de textos, comparando os idiomas. E até na forma como a tradução é lida de volta para o usuário, fizemos ajustes para entender a velocidade ideal e a forma como é falada, para que se entenda o conteúdo o mais rápido possível. Se o sistema percebe que está ficando para trás em relação à fala real, ele aumenta a velocidade da leitura da tradução para que você consiga acompanhar a conversa sem atrasos. Ou seja, há muitas tecnologias trabalhando em conjunto para tornar a experiência fluida e natural.

Microfone dos iPhones

Para isso, revela o executivo, os testes envolveram conversas reais com pessoas de diferentes partes do mundo. Assim, os dados coletados de conversas reais em cada novo idioma são incorporados aos algoritmos.

— Com o Apple Intelligence e com o Tradução ao vivo, adotamos uma abordagem gradual. Lançamos um conjunto inicial de idiomas e depois expandimos. E, para cada idioma que incluímos, há centenas de horas de testes. Trabalhamos com falantes nativos, que cresceram com esses idiomas, para avaliar se as traduções refletem com precisão o conteúdo original.

Agora, o serviço vai incluir italiano, japonês, coreano, chinês tradicional e simplificado. Hoje, além de português, há inglês, e

Fonte original: abrir